IBM muestra el potencial de su chip de emulación cerebral

El chip TrueNorth, diseñado por el gigante azul, podría suponer un avance significativo sobre la eficiencia y la energía de los ordenadores y servidores convencionales dotados de GPU, CPU o FPGA.

IBM ha puesto el foco en desarrollar un ordenador que pueda ser tan decisivo e inteligente como un ser humano. Y, por el momento, ya ha logrado bastantes avances. De hecho, ha diseñado el chip TrueNorth que emula las funciones de un cerebro humano. La compañía está realizando pruebas para demostrar que la velocidad y la eficiencia de los chips pueden ser comparadas a las de los equipos actuales.

El gigante azul asegura que TrueNorth es capaz de participar en deep learning y tomar decisiones basadas en asociaciones y probabilidad. Además, puede hacerlo mientras consume una porción de la energía utilizada por otros chips en otros ordenadores con el mismo propósito.

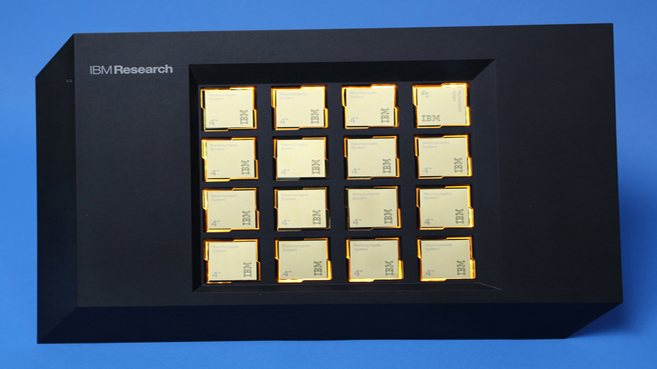

“Sus capacidades abrirán las posibilidades de incorporar la inteligencia a todo el mundo de la computación a través de smartphones, Internet de las Cosas, robots, automóviles, la nube o, incluso, la supercomputación”, ha expresado la organización en su blog oficial. A principios de año, la empresa ya probó el chip en el ordenador NS16e, siguiendo el modelo del cerebro. El equipo podía ser utilizado para imágenes, el habla y el reconocimiento de patrones a través de una red neuronal de unidades de procesamiento.

La mente humana tiene unas 100.000 millones de neuronas que se comunican entre sí mediante conexiones llamadas sinapsis. La corteza cerebral es la responsable del reconocimiento visual mientras que las demás partes se encargan de la función motora. Al igual que el cerebro, NS16e tiene ‘neuronas digitales’, a menor escala, equipado con 16 chips TrueNorth. Cada chip tiene un millón de neuronas y 256 millones de sinapsis. Así, la computadora ha rediseñado la memoria y la comunicación con los subsistemas para facilitar el procesamiento de datos de bajo consumo.

Según la tecnológica, el procesador puede clasificar datos de imágenes entre 1.200 y 2.600 fotogramas por segundo mientras consume solo de 25 a 275 milivatios. Además, puede identificar y reconocer los patrones de las imágenes generadas por unas 100 cámaras a 24 fotogramas por segundo. Puede hacerlo a través de un teléfono inteligente sin necesidad de recargar la batería en días.

El chip supondría un gran avance en cuanto a la energía y la eficiencia de los servidores actuales, que funcionan con chips convencionales como GPU, CPU y FPGA. Facebook, Google, Microsoft y Baidu usan deep learning para encontrar respuestas relacionadas con la formación de imágenes y el reconocimiento de voz.

El potencial de deep learning salta a la vista en los coches autónomos, los cuales utilizan potentes ordenadores para que el vehículo reconozca señales, carreteras u otros objetos. Por el momento, es pronto para ver todas las posibilidades de este chip. IBM comenzó el desarrollo en 2004 y simuló un modelo informático a escala del cerebro de un gato en 2009. Un prototipo de chip en el año 2011 tenía 256 neuronas digitales con capacidades de reconocimiento de patrones. Sin embargo, un equipo completo con un chip que emule toda la actividad cerebral tardará bastante en llegar.

Por su parte, la compañía está construyendo también un ordenador cuántico como opción para reemplazar a los PC y servidores actuales.